广电行业AI加速器上线:推理速度飙升5-8倍,成本节省60%

近日,由中国电子工业标准化技术协会数据存储专业委员会主办的 2025 数据存储产业大会正式揭晓了“2025年度数据存储典型实践案例”名单,大普微联合华瑞指数云:“三节点KVCache存算融合一体机案例”成功入选。

01. 广电行业AI升级:算力与成本的“双重焦虑”

该案例的落地客户是一家行业领先的智算服务提供商。随着广电行业全面进入“智能化内容生产”阶段,AI 模型在内容生成、视频理解、语音识别、虚拟主持人、自动编导等任务的应用呈爆发式增长。然而,在面对实际业务落地时,传统的GPU架构正面临严峻挑战:

1. 极致实时性要求: 视频实时渲染、虚拟演播室交互、直播中的AI特效生成、以及虚拟主持人互动等场景中。毫秒级甚至亚毫秒级的延迟会直接导致音画不同步、动作迟滞或交互卡顿,严重影响最终用户的观感和体验流畅度。

2. 海量上下文数据处理瓶颈: 支撑高质量内容生成和理解(如长视频摘要、复杂场景理解、多轮对话虚拟主持人)需要处理128K+ tokens超长上下文。这导致KVCache数据量激增,读写操作异常频繁。传统GPU架构依赖的高带宽内存(HBM)容量有限且成本高昂,成为制约模型规模、会话长度和并发能力的关键瓶颈。

3. 高并发与高吞吐压力: 规模化推理任务并发数量的激增(如同时处理多个频道的实时渲染、为大量用户提供个性化内容推荐或虚拟主播服务)要求极高的计算吞吐量,更对系统IOPS和内存/存储带宽提出了空前的要求。

4. 容量与成本的矛盾: 单纯依赖高性能GPU搭配HBM的方案虽然算力强,但显存容量有限且单位成本极高。面对需要支撑多用户长会话、大模型多实例部署、以及历史素材库快速检索调用的业务需求,纯GPU方案在容量扩展性和总体拥有成本(TCO)上均难以承受。

5. 复杂模型与异构负载支持: 广电AI应用往往涉及多种模态(文本、语音、图像、视频)的融合处理,以及生成式模型与判别式模型的混合部署。基础设施需要灵活支持Transformer, Diffusion等不同架构和计算特性(计算密集型、访存密集型)的任务,避免资源浪费。

6. 高可用性与弹性扩展需求: 作为支撑核心业务的生产系统,需要极高的稳定性和可用性。同时,需具备弹性伸缩能力,应对业务波峰波谷(如大型直播活动),在保障性能的前提下按需分配资源,优化成本。

因此,客户迫切需要一套能在极致性能、超大容量、灵活扩展性以及可控成本之间取得最优平衡的高性能智算基础设施解决方案。

02. 推理速度提升5-8倍,助力广电行业真正实现AI智能化升级

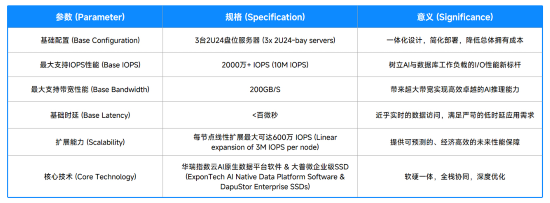

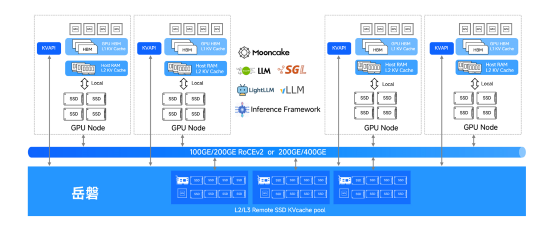

“岳磐”KVCache 存算融合一体机方案是大普微与华瑞指数云联合打造的一款为应对AI与企业核心业务双重挑战而生的全栈解决方案。该方案针对上述行业核心痛点,采用高度集成的“交钥匙”式设计,将大普微高性能企业级SSD与华瑞指数云AI原生数据平台软件产品ExponTech WADP深度融合。通过硬件池化、网络加速与框架调优,解决大模型推理中显存瓶颈与高并发延迟问题,为高实时性的广电行业AI应用场景提供了 PB 级 KVCache 扩展能力与微秒级响应保障。

岳磐方案架构

自方案上线以来,在性能、成本、容量、兼容性等维度全面取得了显著效果:

(1)性能突破:推理速度(TTFT)提升5~8 倍,充分满足大模型推理对 “低时延、高 IOPS” 的严苛要求。

(2)成本优化:实现60% 的推理 GPU 卡成本节省,大幅降低数据中心大模型业务的硬件投入门槛;同时,运维成本在GPU 散热、功耗管理成本同步降低 30%,综合成本优化效果超出预期。

(3)容量释放:提供近似无限的可持久化 memory 空间,彻底摆脱存储容量对大模型业务的制约。单集群可稳定支撑超 PB 级KV Cache 及 Context 数据存储;不仅满足现有大模型 “多会话、长时推理” 需求,还为未来万亿参数级大模型部署预留了充足空间,业务拓展性大幅增强。

(4)兼容灵活:与 vLLM、Mooncake、Dynamo 等主流推理框架无缝兼容,灵活适配不同大模型推理场景的技术需求,全面释放大模型训练推理的效率潜力。

03. 助力广电行业建设“高性能、低成本、可持续”的 AI 智算中心

在高性能存储底座的支撑下,“岳磐KV Cache”联合解决方案已在客户多个核心生产场景中实现了效率的质变:

(1)智能视频剪辑与内容生成

在电视台与视频制作机构中,AI 驱动的智能剪辑系统广泛应用于镜头识别、语音转字幕、片段摘要、自动封面生成等流程。这些任务通常依赖 CLIP、SAM、Whisper 等模型,需要在毫秒级时间内完成图片检索、语义匹配与音频识别。岳磐一体机的高 IOPS 与低时延 KVCache架构让推理任务能够并行处理海量素材文件,显著缩短了素材分析与剪辑时间,从“分钟级”降至“秒级”,有效提升了节目生产效率。

(2)数字人驱动与虚拟演播

数字主持人、虚拟主播、数字孪生演播厅是广电行业近年的创新焦点。 这类业务依赖 Text-to-Speech、Audio2Face、Text2Avatar 等模型实现文本驱动的实时语音与表情生成,推理过程中需要持续加载长序列上下文。传统 GPU 显存难以支撑这种持续性推理,而岳磐一体机的多层 KVCache 架构可实现上下文持久化缓存,使数字人能在长时对话中保持语义一致与自然反应,真正实现实时驱动。

(3)数字孪生与3D演播实时渲染

在虚拟演播厅与数字孪生内容制作中,AI 模型用于实时渲染场景、驱动角色行为或生成环境动态。这类任务对 GPU 与存储间的数据交换速率要求极高。岳磐一体机的存算一体化设计,使 GPU Node 与 KVCache 层之间数据往返延迟降至微秒级,推理速度提升 5–8 倍,保障虚拟演播的实时画面流畅与渲染同步性。

岳磐 KVCache 存算融合一体机方案以其存算融合的 KVCache 架构、低时延互联与高扩展 NVMe 存储体系,显著提升了广电行业的 AI 内容生产效率,也推动了节目制作、虚拟演播与智能渲染的算力革新,为广电行业的智能化升级树立了标杆。

深耕高性能存储,共建 AI 产业新生态

“岳磐” KVCache 存算融合一体机的落地,是大普微将极致性能的 SSD 产品转化为行业系统级解决方案的成功实践。作为企业级存储领域的深耕者,大普微不局限于单一硬件性能的提升,而是通过软硬协同与架构创新,为广电、金融、互联网等关键行业提供量身定制的存储解决方案。凭借持续的技术迭代,大普微正不断拓展存储能力边界,为各行业的数据应用提供坚实支撑。