QLC SSD:AI领域存储的重要选择

在科技的演进历程中,AI技术以其独特的优势逐渐崭露头角。从最初的简单计算到现在的深度学习、生成式AI,AI技术正以前所未有的速度向前发展。在这个过程中,数据成为了推动AI技术进步的关键因素。而为了满足AI对数据存储的需求,QLC SSD凭借其高效扩展能力及极高能效比,成为人工智能应用场景下的重要选择。

01 AI智能进入新赛道,数据存储面临挑战

2018年,OpenAI发布的GPT模型在AI界引发震动,开启了语言处理技术的新篇章。2019年,GPT-3等预训练模型在自然语言处理领域的革命性进步推动了AI技术的实用化,并渗透到各行各业。去年,生成式AI以DALL-E和Stable Diffusion为代表,激发了公众对AI创造能力的广泛兴趣。ChatGPT的问世掀起了“自动文本生成”和“自动语言翻译”的热潮,标志着大型AI模型的数据规模进入“爆炸式”增长期。全球科技企业和研究机构竞相投入资源开发自有模型,但在此过程中,数据存储成为一大挑战。

02 大模型对数据存储规模及处理效率提出的高要求

大模型时代,数据决定AI智能的高度。根据IDC预测,全球数据总量将在2025年达到175ZB;倪光南院士在2023世界半导体大会上表示,预计2025年中国数据量将从7.6ZB增至48.6ZB,超过美国成为全球第一。新兴的AI应用场景对存储需求提出了更高的要求:

高扩展能力:AI工作负载要求存储具备高效扩展的能力,以支撑高质量的输出驱动数据集和日益增长的模型规模所带来的庞大数据量。

满足计算效率:AI服务器计算资源占比高,而内存容量的约束增加了存储设备的访问频率,存储性能优化至关重要。

QLC SSD的高速读取能力和低延迟为AI大型模型快速加载提供高效数据支持,确保整体AI工作流的快速响应及连续性。

高能效存储解决方案:QLC SSD能效比远高于HDD,能够提升存储密度,降低功耗需求,提高智算集群效率,降低TCO。

因此,数据价值最大化的关键课题在于提供大容量、高性能、低能耗的存储解决方案,构建可用、可信、可控的先进存力,以应对大模型时代带来的数据潮汐挑战。

03 大普微QLC SSD J5000

在2024年3月20日CFMS峰会上,大普微正式介绍了PCIe4.0 QLC SSD产品,其提供了两种典型大容量16TB和32TB,同时支持4K映射及双端口特性,可以在核心存储场景替代SAS/SATA HDD,并且顺序读写以及随机读基本上接近同类TLC产品,兼具了HDD的高容量以及媲美TLC的带宽,填补了TLC SSD和HDD之间成本和性能的鸿沟。与此同时,在7G读带宽下仅仅需要12W的功耗,非常适合低功耗、高容量高密存储场景。QLC SSD的高速读取能力及高容量,对于大型AI模型的加载加速、AI推理前的大数据预处理加速、以及为在线推理服务提供高吞吐量的带宽支持,都可以发挥出巨大作用,确保服务的连续性和可靠性。

J5000 QLC SSD vs HDD

以1PB存储集群配置为例,若使用24TB的HDD,需要595块硬盘和50台服务器。而改用J5000系列的32TB QLC SSD,则仅需347块盘片和29台服务器,分别在硬盘和服务器需求上减少了约42%。此外,所需机架空间也减半。在能耗方面,J5000五年的电力消耗成本比HDD方案低30%。作为可直接替换HDD的产品,J5000解决方案能将总体拥有成本(TCO)降低41%,展现出显著的成本效益。

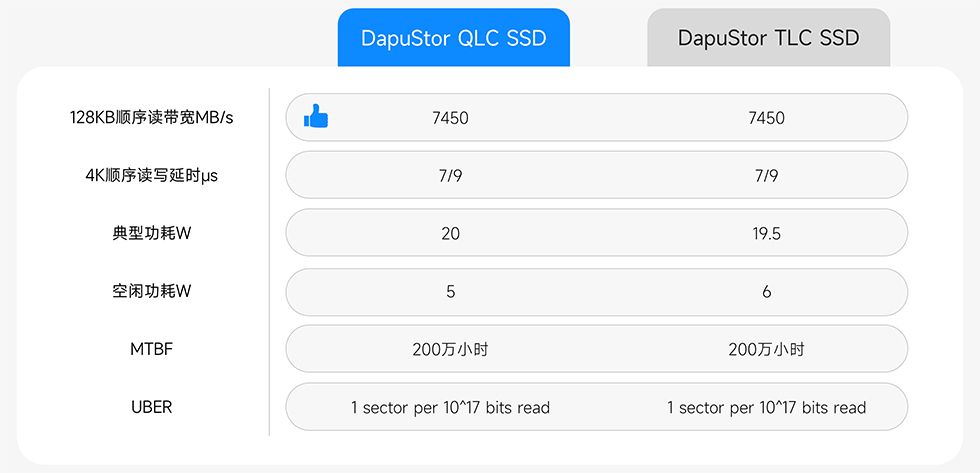

J5000 QLC SSD vs TLC SSD

J5000在实现读取性能媲美TLC SSD的同时,其单位bit成本更低,相同存储密度所需的物理空间更小,TCO对比TLC SSD平均每TB成本降低约20%,因此也成为了存储大量读取密集型数据或对延时不敏感的应用场景的理想选择,如数据中心的温冷数据存储、内容分发网络的边缘缓存及部分云计算平台的冷热数据分离策略。

* 数据来源于大普微实验室,因系统硬件、设置或软件不同,实际测试结果可能存在差异。

总体来说,J5000虽部分性能与TLC SSD仍有差距,但能提供相较TLC SSD更大的存储容量、更低的拥有成本;同时相较HDD拥有更优的性能、效率、空间、电力、冷却成本。

在技术突破和市场策略的推动下,J5000 QLC SSD是大普微为助力AI领域发展而投入的重要产品线,期待通过这一创新产品,发挥关键数据基础硬件的支持作用,推动AI技术的广泛应用 。